Bei der Solaris installation sollten die Array´s nicht mit den Workstation verbunden sein. So kann man die Datei path_to_inst auf beiden Seiten gleich halten.

| Beim Einsatz eines A5100 und nur 5 Platten muss man genau auf die Verteilung achten. Die würde wie folgt aussehen: Vorn: 3 und 6 Hinten: 0, 3 und 6 |

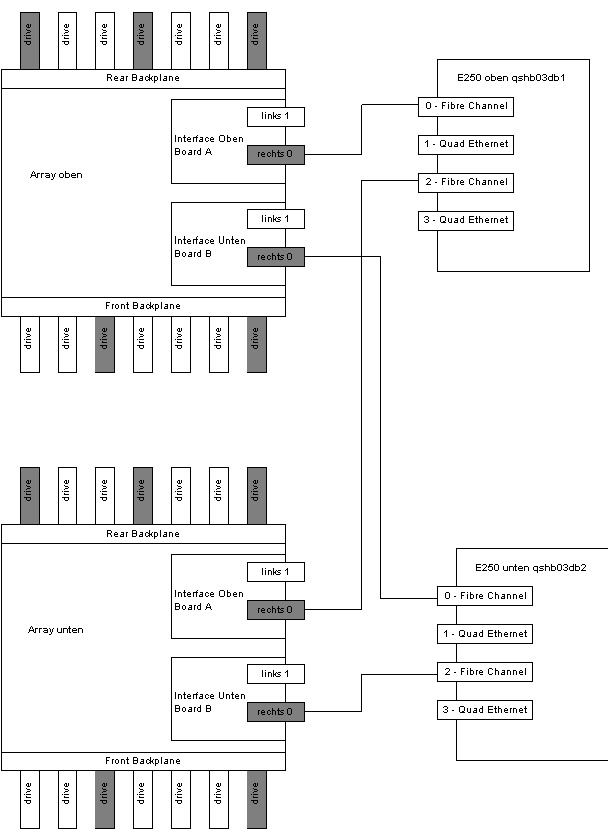

| Steckplatz 0 | Fibre Channel |

| Steckplatz 1 | Quad Ethenet |

| Steckplatz 2 | Fibre Channel |

| Steckplatz 3 | Quad Ethenet |

/etc/system, /etc/path_to_inst, /etc/vfstab